LangChain je okvir koji sadrži višestruke ovisnosti i biblioteke koje se mogu koristiti za izgradnju velikih jezičnih modela. Ovi se modeli mogu koristiti za interakciju s ljudima, ali prvo, model mora naučiti kako dobiti/razumjeti upit/pitanje koje postavlja čovjek. Za to je potrebno model uvježbati na prompt predlošcima, a zatim korisnik postavlja pitanje unutar zadanog predloška.

Ovaj će vodič ilustrirati proces izrade predložaka upita u LangChainu.

Kako izraditi brze predloške u LangChainu?

Za izradu predložaka upita u LangChainu jednostavno prođite kroz sljedeći vodič s više koraka:

Korak 1: Instalirajte module i postavite okruženje

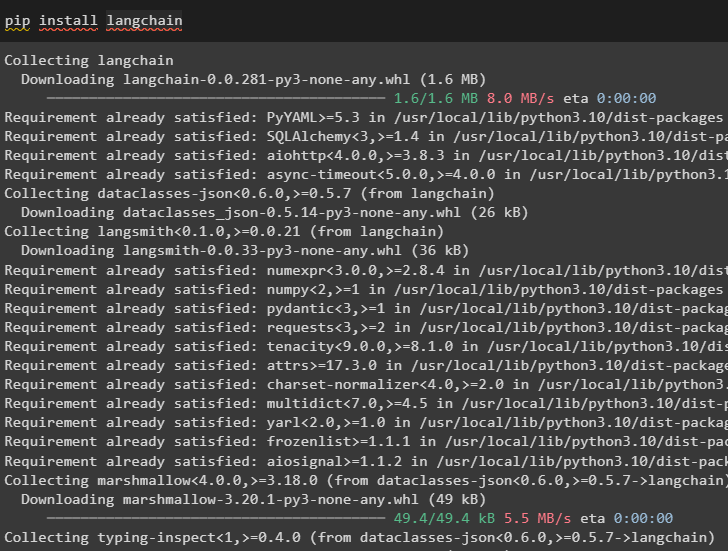

Započnite proces izrade predložaka upita u LangChainu instaliranjem okvira LangChain:

pip instalirati langchain

Sada instalirajte OpenAI module za pristup njegovim bibliotekama i postavite okruženje pomoću njega:

pip instaliraj openai

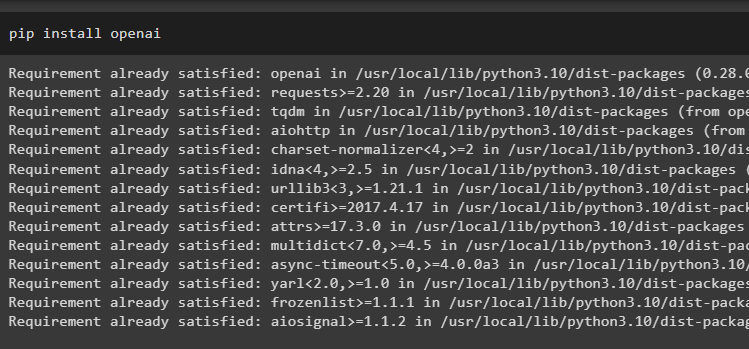

Postavite OpenAI okruženje korištenje os biblioteke za pristup operativnom sustavu i pružanje OpenAI API ključa:

uvezi nasimport getpass

os.environ['OPENAI_API_KEY'] = getpass.getpass('OpenAI API ključ:')

Korak 2: Korištenje predloška upita

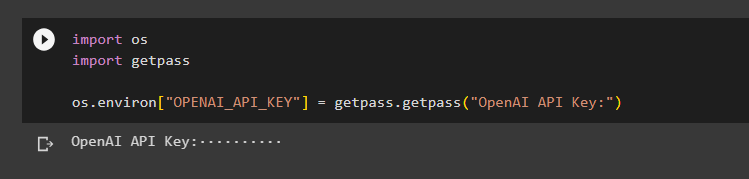

Nakon instaliranja LangChaina, jednostavno uvezite biblioteku PromptTemplate i napravite predložak za upit o šali s nekim dodatnim aspektima kao što su varijable poput pridjeva, sadržaja itd.:

iz langchaina import PromptTemplateprompt_template = PromptTemplate.from_template(

'Reci mi {style} vic o {theme}'

)

prompt_template.format(style='smiješno', theme='kokoši')

Prompt je postavljen i dan modelu s vrijednostima varijable umetnute u naredbu:

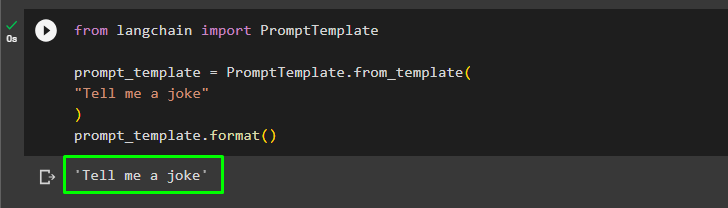

Korisnik može prilagoditi predložak upita jednostavnim upitom koji traži šalu:

iz langchaina import PromptTemplateprompt_template = PromptTemplate.from_template(

'Ispričaj mi vic'

)

prompt_template.format()

Gornja metoda je za jedan upit i odgovor, ali ponekad korisnik želi komunicirati s modelom u obliku razgovora, a sljedeći odjeljak objašnjava njegov format.

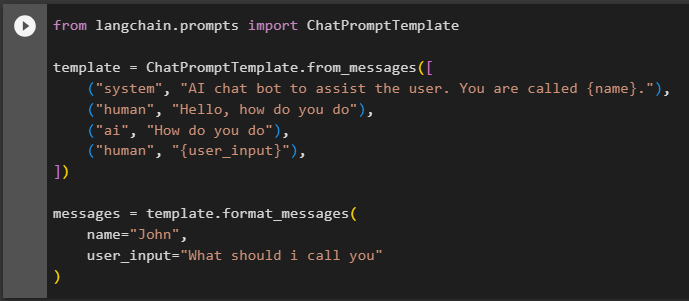

Korak 3: Korištenje predloška upita za razgovor

Ovaj odjeljak objašnjava predložak za model chata koji se temelji na obrascu razgovora kao što je interakcija dvoje ljudi:

from langchain.prompts import ChatPromptTemplatepredložak = ChatPromptTemplate.from_messages([

('sustav', 'AI chat bot za pomoć korisniku. Zovete se {name}.'),

('čovjek', 'Dobar dan, kako ste'),

('ai', 'Kako ste'),

('čovjek', '{user_input}'),

])

poruke = template.format_messages(

ime='Ivan',

user_input='Kako da te zovem'

)

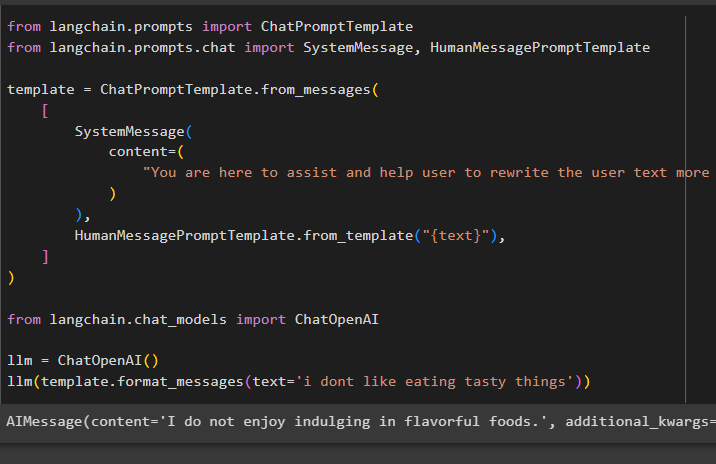

Nakon postavljanja strukture predloška, jednostavno napišite nekoliko redaka u tekstu kako biste modelu rekli što se od njega očekuje i upotrijebite funkciju llm() da biste dali upit:

from langchain.prompts import ChatPromptTemplateiz langchain.prompts.chat import SystemMessage, HumanMessagePromptTemplate

predložak = ChatPromptTemplate.from_messages(

[

SystemMessage(

sadržaj=(

'Ovdje ste da pomognete i pomognete korisniku da učinkovitije prepiše korisnički tekst'

)

),

HumanMessagePromptTemplate.from_template('{text}'),

]

)

iz langchain.chat_models uvozi ChatOpenAI

llm = ChatOpenAI()

llm(template.format_messages(text='ne volim jesti ukusne stvari'))

Metoda SystemMessage() sadrži sadržaj odgovora za upit korišten u LLM-u:

To je sve o izradi prompt predložaka u LangChainu.

Zaključak

Za izradu promptnog predloška u LangChainu jednostavno instalirajte LangChain i OpenAI module za postavljanje okruženja pomoću OpenAI API ključa. Nakon toga izradite predložak upita za jedan upit poput traženja šale ili jednog pitanja o bilo čemu. Druga metoda je prilagodba predloška za model chata na temelju procesa interakcije između dva različita čovjeka. Ovaj post je ilustrirao proces izrade prompt predloška u LangChainu.