Ovaj post će ilustrirati proces izgradnje LangChain aplikacija korištenjem Prompt Template i Output Parser.

Kako izgraditi LangChain aplikacije pomoću brzog predloška i izlaznog parsera?

Da biste izradili LangChain aplikaciju koristeći predložak upita i izlazni parser, jednostavno prođite kroz ovaj jednostavan vodič:

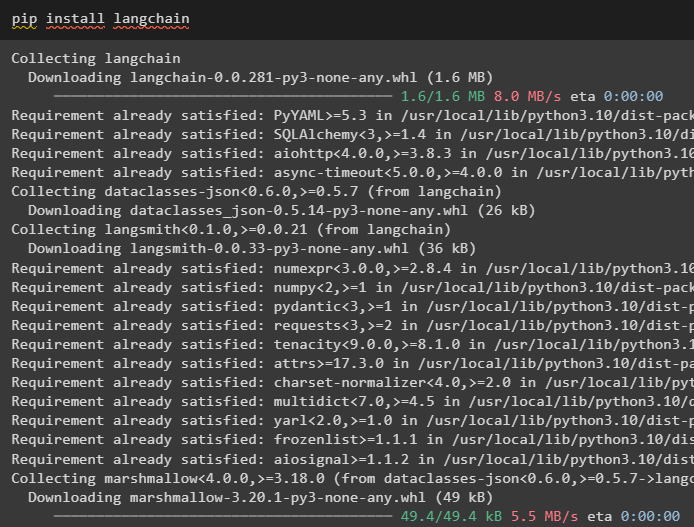

Korak 1: Instalirajte LangChain

Prvo pokrenite proces izgradnje LangChain aplikacija instaliranjem okvira LangChain pomoću ' pip ” naredba:

pip instalirati langchain

Korak 2: Korištenje predloška upita

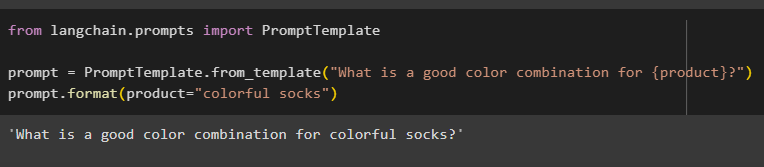

Nakon instaliranja LangChain modula, uvezite ' PromptTemplate ” knjižnica za izradu predloška upita davanjem upita za model kako bi razumio pitanje:

from langchain.prompts import PromptTemplate

prompt = PromptTemplate.from_template('Koja je dobra kombinacija boja za {product}?')

prompt.format(product='šarene čarape')

Izlaz je automatski kombinirao rečenicu s vrijednošću ' proizvod ” varijabla:

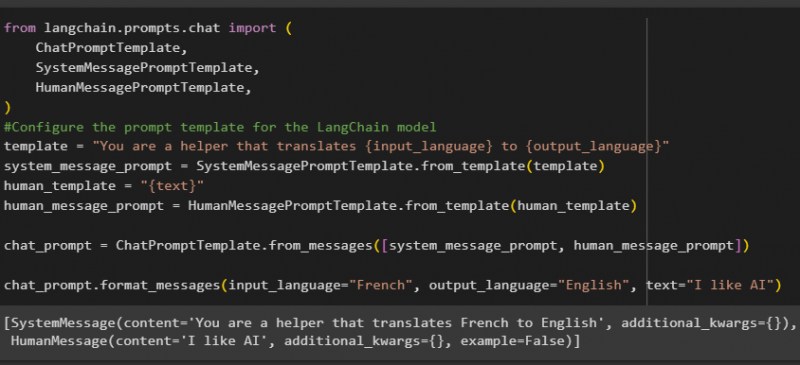

Nakon toga izradite još jedan predložak upita uvozom biblioteka HumanMessagePromptTemplate, ChatPromptTemplate i SystemMessagePromptTemplate iz LangChaina:

iz langchain.prompts.chat import (ChatPromptTemplate,

SystemMessagePromptTemplate,

HumanMessagePromptTemplate,

)

#Konfigurirajte predložak upita za LangChain model

predložak = 'Vi ste pomoćnik koji prevodi {input_language} na {output_language}'

system_message_prompt = SystemMessagePromptTemplate.from_template(template)

ljudski_predložak = '{tekst}'

human_message_prompt = HumanMessagePromptTemplate.from_template(human_template)

chat_prompt = ChatPromptTemplate.from_messages([system_message_prompt, human_message_prompt])

chat_prompt.format_messages(input_language='francuski', output_language='engleski', text='sviđa mi se AI')

Nakon uvoza svih potrebnih biblioteka, jednostavno izradite prilagođeni predložak za upite pomoću varijable predloška:

Predlošci upita koriste se samo za postavljanje predloška za upit/pitanje i ne odgovara nikakvim odgovorom na pitanje. Međutim, funkcija OutputParser() može izdvojiti odgovore kao što je objašnjeno u sljedećem odjeljku s primjerom:

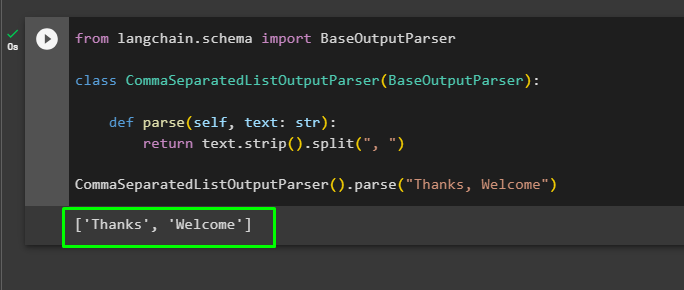

Korak 3: Korištenje izlaznog parsera

Sada uvezite biblioteku BaseOutputParser iz LangChaina da odvojite tekstualne vrijednosti odvojene zarezima i vratite popis u izlazu:

iz langchain.schema import BaseOutputParserklasa CommaSeparatedListOutputParser(BaseOutputParser):

def parse(self, text: str):

vrati tekst.strip().split(', ')

CommaSeparatedListOutputParser().parse('Hvala, dobrodošli')

To je sve o izgradnji LangChain aplikacije pomoću predloška odzivnika i izlaznog parsera.

Zaključak

Za izradu LangChain aplikacije koristeći predložak odzivnika i izlazni parser, jednostavno instalirajte LangChain i uvezite biblioteke iz njega. Biblioteka PromptTemplate koristi se za izgradnju strukture za upit tako da model može razumjeti pitanje prije izdvajanja informacija pomoću funkcije Parser(). Funkcija OutputParser() koristi se za dohvaćanje odgovora na temelju prethodno prilagođenih upita. Ovaj vodič je objasnio proces izgradnje LangChain aplikacija pomoću predloška odzivnika i izlaznog parsera.